背景

nginx-kafka-module是nginx的一個插件,可以將kafka整合到nginx中,便于web項目中前端頁面埋點數據的收集,如前端頁面設置了埋點,即可將用戶的一些訪問和請求數據通過http請求直接發送到消息中間件kafka中,后端可以通過程序消費kafka中的消息來進行實時的計算。比如通過sparkstream來實時的消費kafka中的數據來分析用戶pv,uv、用戶的一些行為及頁面的漏斗模型轉化率,來更好的對系統進行優化或者對來訪用戶進行實時動態的分析。

具體整合步驟

1.安裝git

yum?install?-y?git

2.切換到/usr/local/src目錄,然后將kafka的c客戶端源碼clone到本地

cd?/usr/local/src git?clone?https://github.com/edenhill/librdkafka

3.進入到librdkafka,然后進行編譯

cd?librdkafka yum?install?-y?gcc?gcc-c++?pcre-devel?zlib-devel ./configure make?&&?make?install

4.安裝nginx整合kafka的插件,進入到/usr/local/src,clone nginx整合kafka的源碼

cd?/usr/local/src git?clone?https://github.com/brg-liuwei/ngx_kafka_module

5.進入到nginx的源碼包目錄下 (編譯nginx,然后將將插件同時編譯)

cd?/usr/local/src/nginx-1.12.2 ./configure?--add-module=/usr/local/src/ngx_kafka_module/ make?&&?make?install

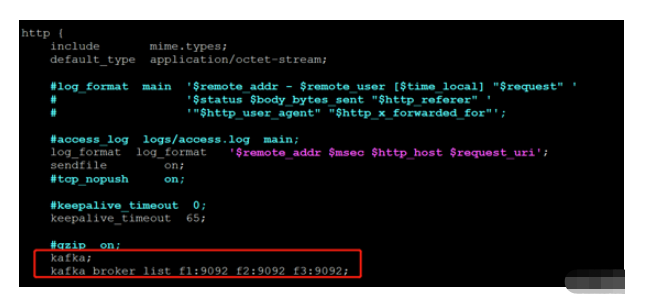

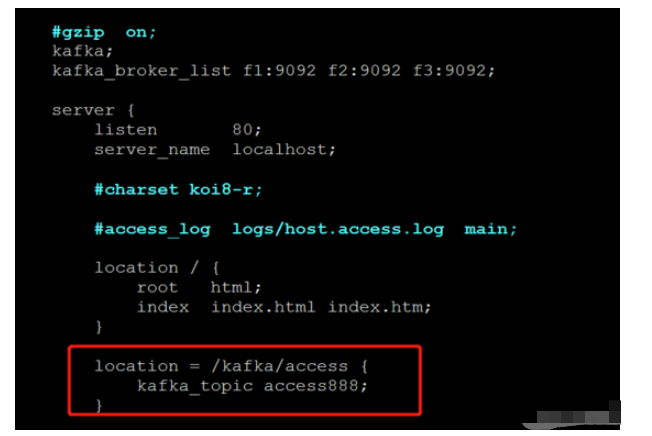

6.修改nginx的配置文件:設置一個location和kafaka的topic

#添加配置(2處) kafka; kafka_broker_list?f1:9092?f2:9092?f3:9092; location?=?/kafka/access?{ kafka_topic?access888; }

如下圖:

7.啟動zk和kafka集群(創建topic)

zkserver.sh?start kafka-server-start.sh?-daemon?config/server.properties

8.啟動nginx,報錯,找不到kafka.so.1的文件

error while loading shared libraries: librdkafka.so.1: cannot open shared object file: no such file or directory

9.加載so庫

#開機加載/usr/local/lib下面的庫 echo?"/usr/local/lib"?>>?/etc/ld.so.conf #手動加載 ldconfig

10.測試,向nginx中寫入數據,然后觀察kafka的消費者能不能消費到數據

curl?http://localhost/kafka/access?-d?"message?send?to?kafka?topic" curl?http://localhost/kafka/access?-d?"小偉666"測試

也可以模擬頁面埋點請求接口來發送信息:

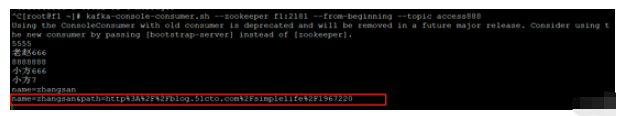

后臺kafka消費信息如圖: