機器學習的核心是監督學習與非監督學習,特征工程決定模型成敗,模型評估需關注精確率、召回率等指標,實戰中應重視代碼框架與動手實踐。1. 監督學習有明確答案,用于預測任務;非監督學習用于發現數據結構;2. 特征工程包括清洗、編碼、縮放和構造,直接影響模型效果;3. 模型評估不能只看準確率,需結合f1分數、auc值等;4. 使用scikit-learn構建標準流程,注重預處理、訓練、預測與評估。

機器學習不是個玄學,尤其用python來實現時,它更像是一套可以逐步拆解的工具和流程。如果你已經接觸過一些基礎內容,但總覺得概念太多、記不住,那這篇文章就是為你準備的。

我們不從理論堆砌開始,而是直接切入重點:機器學習的核心到底是什么?怎么在實際中用起來?

1. 什么是監督學習和非監督學習?

這兩個術語聽起來高大上,其實理解起來很簡單:

立即學習“Python免費學習筆記(深入)”;

-

監督學習(Supervised Learning):你有“答案”的數據,模型的任務是學會根據輸入預測這些答案。

-

非監督學習(Unsupervised Learning):你沒有“答案”,只是想發現數據中的結構或模式。

- 比如:客戶分群,你不知道他們屬于哪一類,只是希望把行為相似的客戶歸為一組。

- 常見算法:K均值聚類、主成分分析(PCA)

還有一種叫半監督學習,就是部分數據有標簽,其他沒有,常用于標注成本高的場景。

2. 特征工程:模型成敗的關鍵

很多人以為調個模型參數就能搞定一切,但實際上,特征工程才是影響效果最大的一環。

特征工程包括:

- 數據清洗(處理缺失值、異常值)

- 特征編碼(比如把“男/女”轉成0和1)

- 特征縮放(標準化、歸一化)

- 特征構造(從原始數據中提取新變量,比如從出生年份算出年齡)

舉個例子:如果你有一個時間戳字段,直接扔給模型可能沒用,但從中提取“星期幾”、“是否節假日”等信息后,模型就更容易捕捉規律。

小建議:用pandas做數據預處理用scikit-learn里的StandardScaler、OneHotEncoder來標準化和編碼不要忽視可視化,matplotlib或seaborn能幫你發現很多問題

3. 模型評估與選擇:別只看準確率

很多人看到模型準確率達到90%就以為成功了,但如果是類別不平衡的數據,這個數字很可能是在“騙人”。

比如:你做一個欺詐檢測模型,正常交易占99%,欺詐交易占1%。即使模型全猜“正常”,也能達到99%的準確率,但這顯然沒用。

這時候你需要關注:

- 精確率(Precision)和召回率(Recall)

- F1分數(F1-score)

- ROC曲線和AUC值

模型選擇方面,不要迷信復雜模型。有時候一個簡單的邏輯回歸比復雜的深度學習模型更好,特別是在數據量小、解釋性強的場景下。

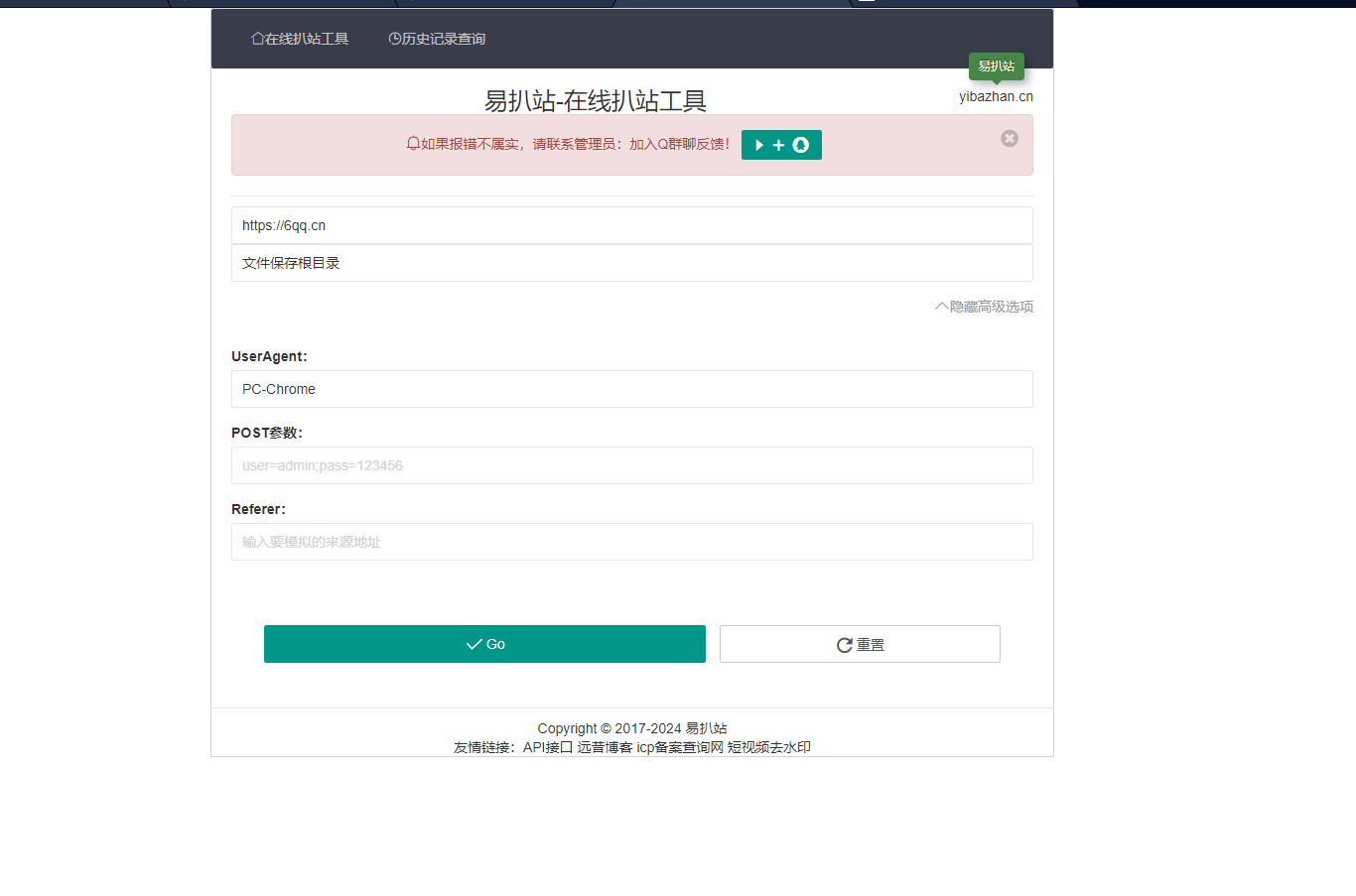

4. Python實戰要點:代碼框架長什么樣?

用Python做機器學習,最常用的是scikit-learn庫,它的接口統一,容易上手。

一個基本流程大概是這樣:

from sklearn.model_selection import train_test_split from sklearn.ensemble import RandomForestClassifier from sklearn.metrics import accuracy_score # 加載數據 X, y = load_data() # 劃分訓練集和測試集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2) # 初始化模型 model = RandomForestClassifier() # 訓練模型 model.fit(X_train, y_train) # 預測結果 y_pred = model.predict(X_test) # 評估性能 print("Accuracy:", accuracy_score(y_test, y_pred))

這只是一個骨架,實際中你要加數據預處理、交叉驗證、調參等步驟。不過整體結構大致如此。

基本上就這些。機器學習看起來很復雜,但當你把它拆成幾個模塊來看,每個部分都并不難掌握。關鍵是動手實踐,邊做邊理解,而不是死記硬背一堆名詞。